ChatGPT刚出来的时候,2023年我们想调用API来做网站客服机器人,程序都调通了,但花费太大,不敢多用。后来经过几次降价,2024年初GPT-3.5的价格勉强可以接受了,我们用于批量生成一些多语言的内容,但GPT-4的价格依然让人不太敢用。

老版本的DeepSeek在2024年5月领头大幅降低API价格,引得国内大模型厂商掀起价格战,部分较小模型甚至免费,国外也有一些厂商用限额试用等方式促销。而Llama-3系列开源的LLM模型让推理服务商的成本降低,我们从火山引擎、Groq、Hugging Face都拿到一些免费API资源,从而让AI应用可以落地。

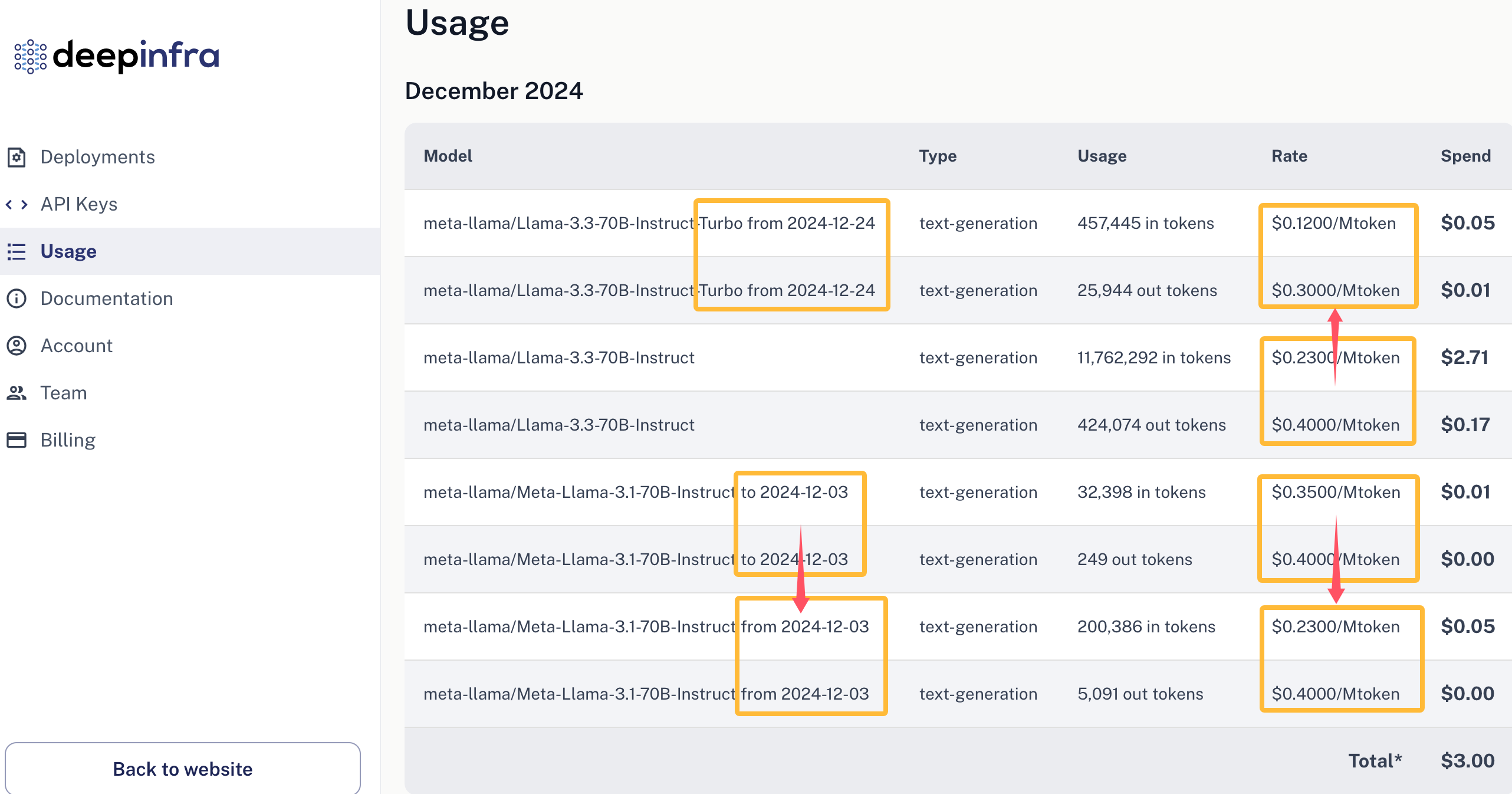

Emoji角色聊天算是一个比较快看到有用户喜欢的产品,每天有几千次的模型调用、数千万token的消耗,火山引擎的Llama-3-70b质量差了一点,Groq的Llama-3.1-70b基本可以但每天50K tokens免费额度太少,Hugging Face的Llama-3.1-70b额度达到每天2万次调用,但却速度卡、不稳定。后来经过比较,采用DeepInfra的Llama-3.1-70b,API成本为输入$0.35/M tokens,输出$0.4/M tokens,每天4000次调用、每次1k输入/0.1k输出 tokens、20M tokens的费用大约是7美元,将每次调用API粗略算为一次页面刷新的话,费用就是$1.75/千次页面展示,与AdSense广告的收入在同一个数量级上了。

进一步在2024年12月3日,输入token价格下降,为以前的2/3,而2024年12月24日推出的8bit量化Llama-3.3-Instruct-Turbo版本,输入token价格再下降到此前的1/2,这样一个月之内我们的成本变为以前的1/3,每天20M tokens的费用大约2美元,折合大约$0.5/千次页面展示,已经低于我们这个Emoji网站的$0.8/千次页面展示的AdSense广告单价了。

当然,这只是一个粗略统计和比较,1000次API调用的对话界面滚动与1000次页面展示相比,前者的广告展示和刷新效果还是差一些。所以目前综合来看,算力API调用的成本依然高于能产生的AdSense广告收入。但算力成本在2025年和以后会不断下降,所以迟早API调用的成本会低于能产生的广告价值,甚至比较初级的模型的算力成本会逐步趋近于零。

鉴于这样,我有几点想法:

- AI应用的初期不用过于考虑成本,总是需要花费一些学费来打磨技术、积累用户的;

- 要做就做能批量使用算力的应用,要么是大量API来生成公开的固定内容,要么是大量API来生成个人需要的独特内容,用户量少了就没有太大意义;

- 选择广告价值高的领域来做AI应用可能更早地获得足够的收入;

- 考虑没有AI的时候做不了的工作,只有AI出现后才能做的应用项目。

这个春节前DeepSeek这条大鲶鱼放出V3、R1推理模型并开源,OpenAI和Google也都纷纷推出新产品来应战,他们之间越是竞争,价格也会越低,对我们这些AI应用开发者来说都是很好的机会。

评论