上一篇博客《有人恶意刷百度关键词陷害我们网站》写的是百度对一些黑帽SEO手段判断的不准确,导致我们网站被陷害。百度的作弊识别算法还不够完善,需要人工去发现、处理。我们觉得Google的作弊识别算法应该更好,但最近我们网站上发生的问题让我们看到Google的算法也是有漏洞可以钻的。😒

一、问题的发现:

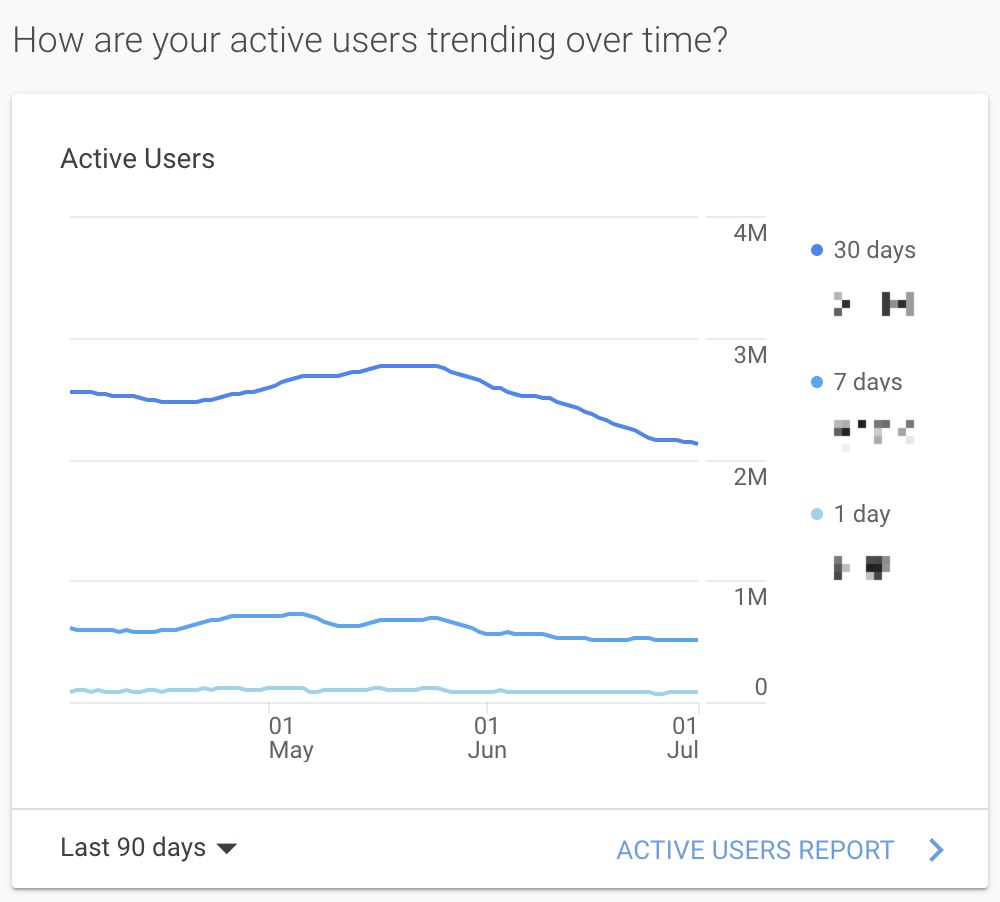

去年6月我们有一个站在Google的核心算法更新后就遇到流量下降,直到11月核心算法再次更新后流量才恢复,但核心算法的更新为什么会影响我们网站流量、具体问题出在甚么地方?这些问题一直没有搞懂。

今年5月Google的核心算法更新后,我们这个站的流量再次明显下滑,这次我们就没有再等半年了,而是仔细分析数据查找原因。

二、问题的分析:

在此之前一段时间,我们就在Drupal日志、Apache日志中发现过一些奇怪的搜索,关键词里面带有明显的黑产内容,例如博彩、代考、色情等,当时没有引起足够的重视。

在Google中site搜索我们域名,竟然发现很多带有这种关键词的搜索页面网址也被Google收录了,数量非常庞大!😱

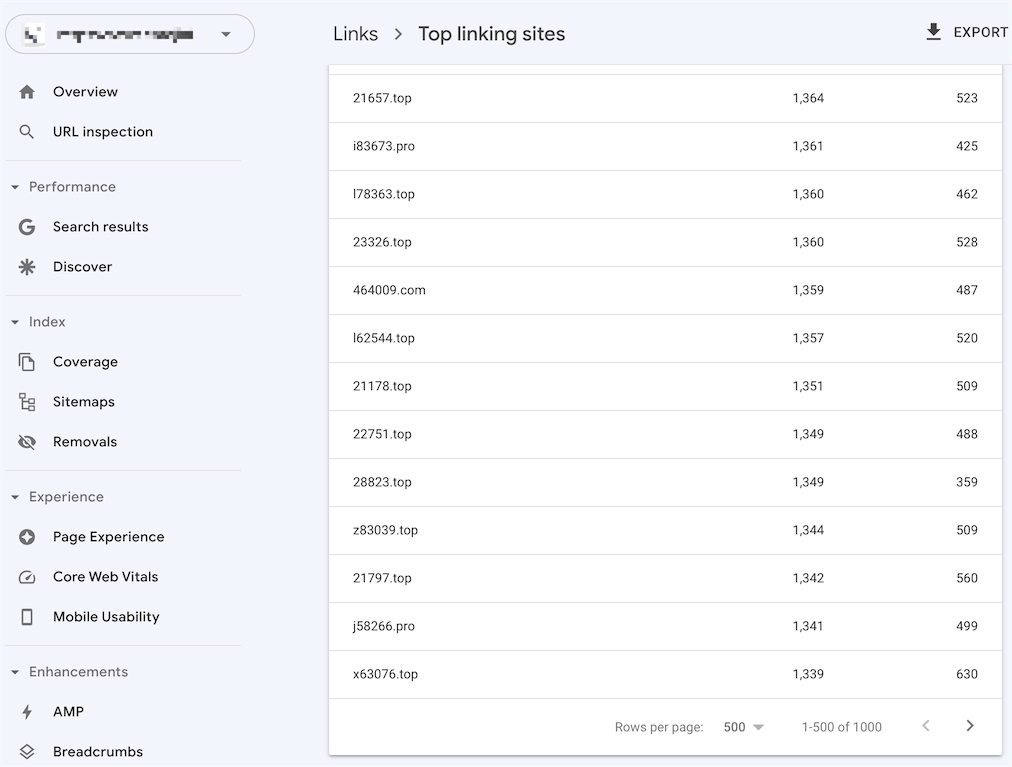

而在Google Search Console中查看外部链接,竟然有上千个一看就是垃圾域名的网站指向我们,并且每个网站都是给我们网站提供了很多链接,再去打开这些网站看的时候发现基本都打不开了。

我们估计是这种垃圾网站(域名就多达上千)制造的垃圾链接太多(十万、百万数量级以上),而Google的反作弊算法还无法准确识别,认为是我们网站自己故意这样做的而遭到降权惩罚。

三、问题的解决:

既然找到了问题,那么就需要有办法来解决,下面是一些文章:

- Google Search Console帮助中心:《拒绝指向您网站的链接》

- Google Search Console帮助中心:《“移除”工具和“安全搜索”举报工具》

- Matt Tutt Digital Marketing Blog: “Dealing with Indexed Spam or Injected SEO Spam Content”这篇文章写得比较详细

- 维基百科:《HTTP状态码#4xx客户端错误》

我们采取了下面几项措施:

- 对垃圾链接进行识别和屏蔽:刚开始用Cloudflare的Web应用防火墙进行屏蔽,状态为403,后来改为.htaccess中进行设置,状态使用410,另外对搜索页面的标题、head中标记、无结果页面的显示等地方也做了修改,防范站内搜索被利用;

- 在Google Search Console中提交否认:将上千垃圾域名导出、检查处理后提交到"拒绝指向您网站的链接";

- 在Google Search Console中提交删除:将发现已经收录的垃圾链接提交给Google进行删除(6个月有效)。

另外,也在Google Search Console中填写了反馈,目前还在等待中。⏳

2022年10月24日补充:我们有个域名受到垃圾链接影响很长时间了,而且很难查到具体来源,因为那些垃圾网站的域名可用性很短,等搜索引擎站长平台中显示这些垃圾外链网站的域名时,去访问这些网站已经打不开或者部分页面打不开了,现在这种垃圾链接已经产业化,新域名有成千上万个不断出现,搜索引擎短期内无法辨别,可能导致误认为是我们自己在作弊而影响我们网站的权重。还有一个办法可以尝试:robots.txt中增加屏蔽,也就是把可能的垃圾链接形式收集整理后,按照robots.txt中Disallow屏蔽的写法写进去,注意可以用一些robots.txt验证平台进行验证,避免误屏蔽正常网址。

评论