去年开始就在了解开放数据领域的情况,当时记录了《各国(地区)政府开放数据网站》、《美国州县市政府开放数据网站》,后来今年初在考虑把一些数据做成网站形式让大众浏览的时候,还记录了《什么样的开放数据适合做网站?》,2、3月份在美国远程工作,也尝试添加了一些内容到U.S. Open Datasets这个新站,还在上面《什么样的开放数据适合做网站?》这篇博文后面添加了一些新的想法:

- 编码类:编码类数据集类似词典的结构,比较简单,但基本上没人能够记住编码及含义,都需要查资料,所以这类信息还是有用的,只是可能不经常查,或者只是局限于某个领域的人有需求;

- 复杂性:国外有些数据集相当复杂,由很多表组成,这些表之间还有关联,呈现出来比较麻烦,不过如果能值得多花些时间精力搞懂结构的话,也是可以做出来的,并且有一定难度的工作才能体现我们做得比别人好;

- 专业性:涉及到医疗医药、金融保险、统计分析等方面的数据,有些是相当晦涩难懂的,很多专有名词、缩写、代码,首先要能基本明白数据内容、针对什么样的用户,以便能判断是否采用、如何采用;

- 广告价值:最近还和一位专门做美国生活类网站的朋友聊过,他们是专门挑选高价关键词来做针对性网页内容,页面数量不多、网站流量不算高,但广告点击率、价值和总体收入都不错,我们在做数据集、长尾网站的时候,也可以借鉴,更多选择价值高的领域的数据来做。

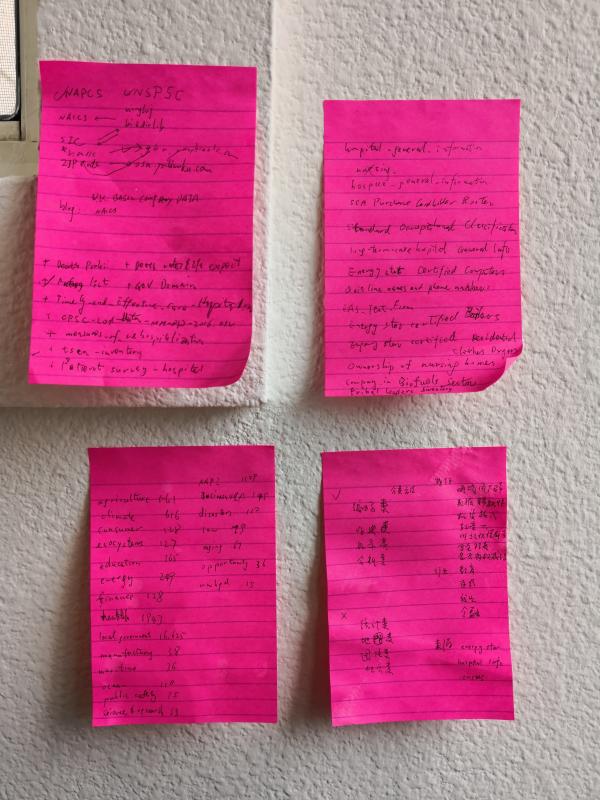

但因为data.gov里面的数据量太大,数据集有二十多万,对全貌掌握还不够,所以上个星期花了几天的时间专门来看这个站里面的内容,并记下来一些纸上,现在干脆整理成博客文章,把一些过程和要点记录如下。

前期我按照流行度来查看美国政府开放数据,选择里面浏览者多的内容仔细查看,并把适合的做成网站内容。这次在我首先是进行了一些过滤,20多万数据中属于地理信息类的有超过15万,属于非地理信息类的大约8万,因为地理信息类的我们大多数都不太好做成网站所以就把这部分先去掉了,再只选择了来自联邦政府的数据,去掉了来自州、县、城市的地方性数据,剩下大约7万,另外就是按照适合做成网站的文件格式,把txt和csv的先看了,其中txt过滤出来大约有350个,csv过滤出来大约有2000个。

这350个txt的数据集花了1天时间来查看,也是按照流行度排序来查看,有些明显不适合我们用的就不打开看了,有可能用的就打开单独的页面看,再需要仔细了解就下载文件到本地打开查看,还有些需要访问数据来源网站去详细了解,如果要做成网站,甚至还有需要单独Google搜索找其它来源了解。

有了一定经验后再看2000个csv数据集稍微快点,但也是花了1、2天的时间来查看。看英文的有些慢,我就启动Chrome浏览器的自动翻译功能,这样能比较快一眼就知道大概情况,不感兴趣的就快速略过,感兴趣的再对照原文仔细看。下载了几十个文件来查看,最后留下大约20个左右文件觉得是做成网站适合的,例如:

- Demographic Statistics By Zip Code

- North American Industry Classification System (NAICS)

- North American Product Classification System (NAPCS)

- UNSPSC Codes

- Patent and Trademark Practitioners (Intellectual Property (IP) Agent/Attorney/Barrister/Lawyer)

-

等等,我写在纸上的还有几十个以后可能补到这里

上面图片就是我记录的一些内容,整理起来有些麻烦,我可能就等下个月回国后直接和同事讲算了。

再进一步,我按照大的分类把各个分类的数量记录下来,数量少的我翻看了前几页,也就大约知道了各个领域的数据集数量:

- Agriculture 农业:561

- Climate 气象:616

- Consumer 消费者:128

- Ecosystems 生态:127

- Education 教育:365

- Energy 能源:249

- Finance 财经:128

- Health 健康:1943

- Local Government 地方政府:16625

- Manufacturing 制造业:38

- Maritime 海事:36

- Ocean 海洋:110

- Public Safety 公共安全:75

- Science & Research 科学研究:33

- AAPI:1109

- BusinessUSA:145

- Disasters:110

- Law:79

- Aging:67

- Opportunity:36

- wwhgd:15

我认识的做AdSense的站长几乎没有愿意把自己的网站或者想法告诉别人的,好像很防范被别人复制内容或者抄袭了创意,国内确实各种采集、Copy等乱七八糟的情况多,不过我觉得有能力的人做出来的东西是不怕透露、不怕抄袭的,抄袭的永远跟着后面,只有深入研究用户需求、研究新技术才能走在前面。

像这样真的要了解透彻各种国外网上公开数据可不是一个轻松的事情,语言障碍、文化习惯了解、技术选型实现、后期维护、分析改进都是必须克服的,有难度也才能有门槛有收益。

网上有一些现成的对美国政府公开数据的中文文章,我都看过,基本上都是学术界或者政府角度的分析或者论文。我博客以后还会持续以自己的视角记录一些了解、分析、采用、结果,欢迎交流。

附图:我在美国San Diego租住的房间,墙上贴了一些工作相关记录要点即时贴。

评论