最近幾天我們國内的兩個網站都遇到訪問困難,檢查發現是百度爬蟲抓取量大增,是以前正常情況的很多倍,導緻Web服務器CPU、帶寬以及數據庫服務器都難以應付。Googlebot也曾經出現類似情況。

辦法一(站長平台設置):

按照以前的辦法,我們是在百度資源平台或者Google Search Console中設置降低爬蟲的抓取速率,不過這樣設置後需要等待2-3天時間生效,而不能解決當時的問題。

這是 爬蟲 分類的頁面,點擊下面标題查看詳細文章内容:

最近幾天我們國内的兩個網站都遇到訪問困難,檢查發現是百度爬蟲抓取量大增,是以前正常情況的很多倍,導緻Web服務器CPU、帶寬以及數據庫服務器都難以應付。Googlebot也曾經出現類似情況。

按照以前的辦法,我們是在百度資源平台或者Google Search Console中設置降低爬蟲的抓取速率,不過這樣設置後需要等待2-3天時間生效,而不能解決當時的問題。

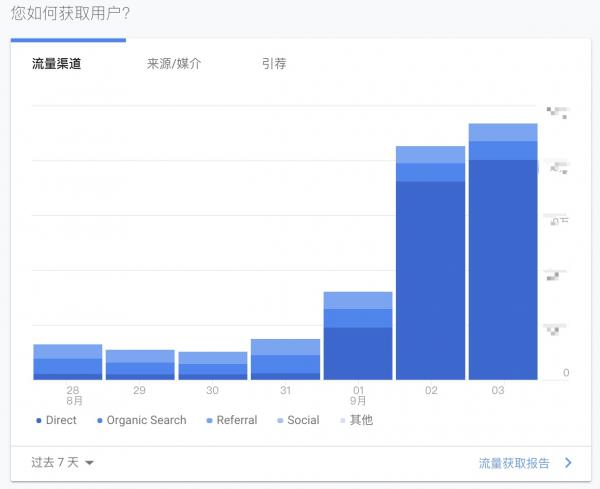

最近幾天我們有兩個域名下的網站從Google Analytics看流量異常增高,是平時的數十倍,同時在線人數也是以前的幾十倍,從流量來源看主要是直接來源用戶大量增加,這顯然是不正常的。截圖如下:

從相同網站的百度統計、Google AdSense數據來看卻沒有明顯變化,隻是Google Analytics

标明訪問者屬性的User Agent是可以由軟件進行修改的,所以有很多采集者為了防止自己被屏蔽,就把User Agent改為搜索引擎爬蟲的特征,例如:

我們很早前就開始做百度MIP版本頁面了,通過這種方式也獲得了流量的增長和比較好的用戶體驗。但最近流量不太穩定,有的站MIP流量曾經很高,但後來跌落很厲害。還有的站MIP流量下降後,對應的普通WEB版流量上升。

我們做了各種推測和試驗,今天發現了一條重要線索:百度的MIP爬蟲曾經被我們屏蔽。

按照百度官方的說法,其MIP爬蟲的User Agent是這樣的:

Mozilla/5.0 (Linux;u;Android 4.2.2;zh-cn;) AppleWebKit/534.46 (KHTML,like Geck

最近新增了一些網站内容,結果正常的訪問者還沒有開始來,采集的爬蟲就來了,真像是嗜血的鲨魚,發現哪裡有美味馬上就盯上了😰。

近期也看了一些關于反采集的文章,世上沒有完美、一勞永逸的反采集辦法,成了與采集者的對峙,雙方不斷變換對抗辦法,成了一種體力活。

我們現在也不得不采取更嚴格的反采集措施,看到很多采集IP都來自amazon雲計算,這就可以用hostname反查來進行屏蔽,以前曾經做過測試,今天再次測試并記錄。

在apache的httpd.conf文件中添加一行:

HostnameLoo

我們在采用《使用Apache模塊mod_qos反采集》的辦法以後,确實有一些效果,但從apache報錯日志中看到也有百度、Google等搜索引擎的IP被屏蔽了,現在來收集整理一下常見搜索引擎的IP地址段,以便加入白名單中:

Googlebot:

Baiduspider:

我們一些大數據量的網站總是淪為爬蟲獲取信息的對象,導緻大量消耗服務器資源。有些爬蟲是為了采集整個網頁,也有些隻來找尋郵箱等聯系方式信息。

前段時間發現有一陣爬蟲特别多,從apache日志裡面看到這樣的特征:

115.151.110.238 - - [14/Jul/2018:18:03:01 +0800] port:443 "liaoning.mingluji.com" "GET /%E5%AE%89%E5%BE%BD%E5%A5%BD%E6%80%9D%E5%AE%B6%E6%B6%82%E6%96%9

自從做網站以來,大量自動抓取我們内容的爬蟲一直是個問題,防範采集是個長期任務,這篇是我5年前的博客文章:《Apache中設置屏蔽IP地址和URL網址來禁止采集》,另外,還可以識别User Agent來辨别和屏蔽一些采集者,在Apache中設置的代碼例子如下:

RewriteCond %{HTTP_USER_AGENT} ^(.*)(DTS\sAgent|Creative\sAutoUpdate|HTTrack|YisouSpider|SemrushBot)(.*)$

RewriteRule .* - [F,L]

屏蔽User

以前托管服務器或者租用的服務器一般都是100M共享的帶寬,很少出現機器帶寬被占滿的情況,去年開始采用阿裡雲平台後,帶寬就是一個不得不考慮的成本因素,我們一般都是每台ECS購買的10M左右帶寬,每年費用已經不少了,而投入使用後很輕易就會被占滿,關鍵是網站的流量并沒有特别提升,廣告收入沒有增加,成本卻在大幅提高,還導緻正常用戶訪問變慢、困難。

同事在Linux服務器上安裝了一個iftop來查看帶寬占用情況,很容易就發現了是搜索引擎的爬蟲抓取sitemap.xml這樣的網址占用了很大帶寬,我們網站系列多、頁面多、還有多語言或者手機版,網站地圖就特别的多,如果爬蟲來得

網站内容抓取采集真是中國互聯網的一大特色,我們做了這麼多年網站,一直都遇到各種各樣對我們内容進行采集、複制的家夥。前一陣子發現一個網站 www.postcodequery.com 具體和我們的 www.postcodebas

2002-2023 v11.7 a-j-e-0